Navigation auf uzh.ch

Navigation auf uzh.ch

Hasserfüllte Kommentare (engl. Hate Speech) im Internet sind zu einem weltweiten Problem geworden. In sozialen Netzwerken werden sexuelle Minderheiten diffamiert, Angehörige bestimmter Religionsgemeinschaften eingeschüchtert und ethnische Gruppen aufgewiegelt. Hate Speech ist aber auch eine Bedrohung für die Demokratie, da sie die Angegriffenen davon abhalten kann, sich an einer öffentlichen Diskussion zu beteiligen.

Zwar verfügen viele Plattformen über teils ausgeklügelte Filter, um Hasskommentare zu löschen. Doch diese allein können das Problem nicht wirklich eindämmen. Facebook zum Beispiel ist nach eigener Einschätzung (beziehungsweise gemäss den im Oktober 2021 geleakten internen Dokumenten) nicht in der Lage, mehr als 5 Prozent der geposteten Hasskommentare zu entfernen. Dazu kommt, dass die automatischen Filter ungenau sind und tendenziell im Konflikt mit der Meinungsäusserungsfreiheit stehen.

Eine Alternative zum Löschen ist gezielte Gegenrede (engl. Counterspeech). Counterspeech wird von zahlreichen Organisationen verwendet, die sich im Internet gegen Hate Speech einsetzen. Wissenschaftliche Erkenntnisse zur Effektivität dieser Strategie gab es bisher aber kaum. Ein Forschungsteam um Fabrizio Gilardi, Professor für Policy Analysis und Karsten Donnay, Assistenzprofessor für Political Behavior und Digital Media, vom Digital Democracy Lab der UZH und Dominik Hangartner, Professor für Politikanalyse an der ETH, hat nun untersucht, welche Botschaften Hassrednerinnen und Hassredner dazu bewegen können, dies in Zukunft zu unterlassen.

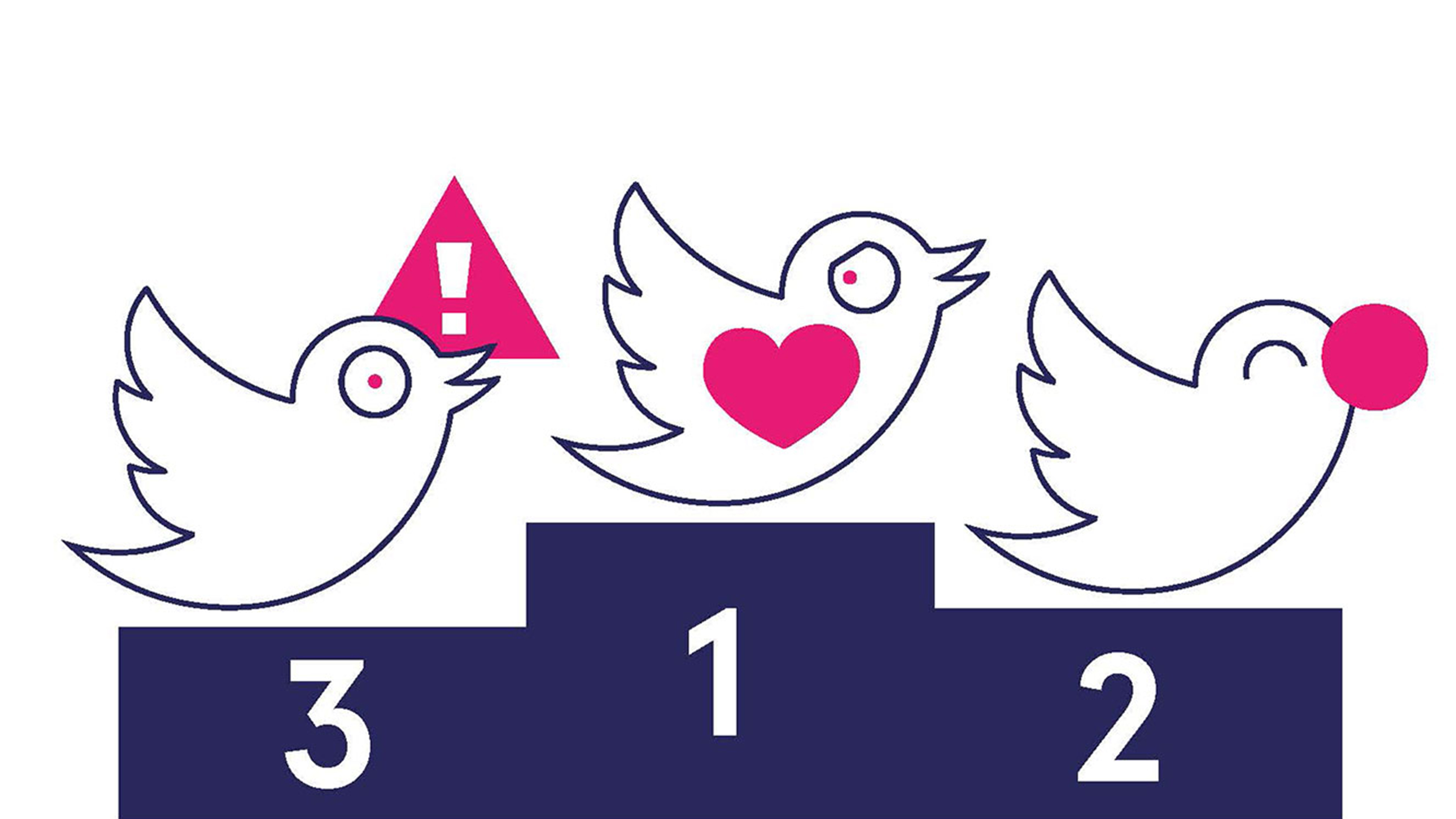

Mit Methoden des maschinellen Lernens identifizierten die Forschenden 1350 englischsprachige Twitter-User, die rassistische oder fremdenfeindliche Inhalte publiziert hatten. Einen Teil dieser Hass-Twitternden teilten sie einer Kontrollgruppe zu, auf die anderen wandten sie nach dem Zufallsprinzip eine von drei häufig verwendeten Counterspeech-Strategien an: Nachrichten, die Empathie mit der von Rassismus betroffenen Gruppe erzeugen, Humor oder einen Hinweis auf mögliche Konsequenzen.

Die Ergebnisse, die soeben in der Wissenschaftszeitschrift Proceedings of the National Academy of Sciences publiziert worden sind, fallen deutlich aus: Nur Antworten, die Empathie mit den von der Hassrede betroffenen Personen erwirken, sind geeignet, die Hass-Schreiber zu einer Verhaltensänderung zu bewegen. Eine solche Erwiderung könnte beispielsweise lauten: «Ihr Post ist für Jüdinnen und Juden sehr schmerzhaft…». «Diese Effekte sind nicht sehr gross aber durchaus spürbar: die Hass-Schreiber verschickten in den folgenden vier Wochen im Durchschnitt 1,3 weniger fremdenfeindliche Tweets als die Kontrollgruppe und haben eine um 8,4 Prozentpunkte höhere Wahrscheinlichkeit, ihren fremdenfeindlichen Tweet zu löschen», sagt Donnay.

Auf humorvollen Counterspeech reagierten die Hass-Twitternden hingegen kaum. Selbst der Hinweis, dass auch Familie, Freunde und Kollegen des Senders dessen Hass-Nachrichten sehen, wirkte nicht. Das ist insofern bemerkenswert, als diese beiden Strategien häufig von Organisationen, welche sich gegen Hassrede einsetzen, angewandt werden.

«Wir haben sicher kein Allzweckmittel gegen Hate Speech im Internet gefunden, dafür aber wichtige Hinweise, welche Strategien funktionieren könnten und welche nicht», sagt Dominik Hangartner. Noch zu untersuchen bleibt, ob alle Empathie-basierten Antworten gleich wirken oder ob bestimmte Formulierungen effektiver sind. Zum Beispiel können Hassredner aufgefordert werden, sich in das Opfer hineinzuversetzen. Oder man kann sie bitten, eine analoge Perspektive einzunehmen («Wie würdest Du Dich fühlen, wenn Leute so über Dich sprechen würden?»).

Eine massgebliche Rolle spielten im Projekt 13 Master-Studierende des ETH Center for Comparative and International Studies (CIS). Die Studierenden wirkten in allen Phasen des Projekts mit, von der Entwicklung eines Algorithmus zum Erkennen von Hass-Tweets über das Testen der Strategien bis zur statistischen Analyse und dem Projektmanagement. Die Verantwortlichen betrachten diese «neue Art eines kollaborativen Forschungsseminars für exemplarisch».

Positiv äussern sich auch involvierte Studierende. «Wir haben nicht nur über die Forschung anderer gelesen, wir wissen jetzt auch, wie ein grösseres Forschungsprojekt funktioniert», sagt zum Beispiel Laurenz Derksen. «Auch wenn der Aufwand gross war: Die Untersuchung hat ein Feuer in mir entfacht und mich für die ambitionierte und kollaborative Forschung begeistert», meint Derksen. Motivierend sei auch, dass alle 13 Studierenden in einer der renommiertesten interdisziplinären Fachzeitschriften als Co-Autoren aufgeführt sind. «Ich habe an einer an Untersuchung mitgearbeitet, die nicht nur wissenschaftlich publiziert wurde, sondern auch in der realen Welt etwas bewirken könnte», sagt Doktorandin Buket Buse Demirci.

Das kollaborative Forschungsseminar ist Teil eines umfassenderen Projekts zur Entwicklung von Algorithmen zur Erkennung von Hassrede und dem Testen und Verfeinern von weiteren Counterspeech-Strategien. Dabei arbeitet das Forschungsteam mit dem Frauendachverband alliance F zusammen, welche das zivilgesellschaftliche Projekt Stop Hate Speech (https://stophatespeech.ch/ ) initiiert hat. Durch die Zusammenarbeit gewinnen die WissenschaftlerInnen direkte Erkenntnisse aus der Praxis und liefern eine empirische Basis, damit alliance F den Einsatz und Inhalt der Gegenrede optimieren kann.

«Die Forschungsergebnisse stimmen mich sehr optimistisch. Das erste Mal liegen uns Ergebnisse vor, welche mittels eines unter realen Bedingungen durchgeführten Experimentes die Wirksamkeit von Counterspeech empirisch belegen können», sagt Sophie Achermann, Geschäftsführerin von alliance F und Co-Initiantin von Stop Hate Speech. Weiter beteiligt an dem von der Schweizer Innovationsförderagentur Innosuisse geförderten Forschungsprojekt sind unter anderem die Medienhäuser Ringier (Blick) und TX Group (20 Minuten).